Ceph的搭建流程及openshift上使用ceph-rbd实现动态存储

Ceph分布式块存储部署机器列表 名称 核数 内存 ip hostname 外挂磁盘大小(G) 管理节点admin 2 4 192.168.1.2 admin.ceph.com 监控节点monitor 2 4 192.168.1.3 monitor.ceph.com 存储节点node1 2 4 192.168.1.4 node1.ceph.com 100G 存储节点node2 2 4 192.168.1.5 node2.ceph.com 100G 部署Ceph RBD 1、给每台机器设置hostname 12345# 设置hostname hostnamectl --static set-hostname admin.ceph.com #192.168.1.2 hostnamectl --static set-hostname monitor.ceph.com #192.168.1.3 hostnamectl --static set-hostname node1.ceph.com #192.168.1.4 hostnamectl --s...

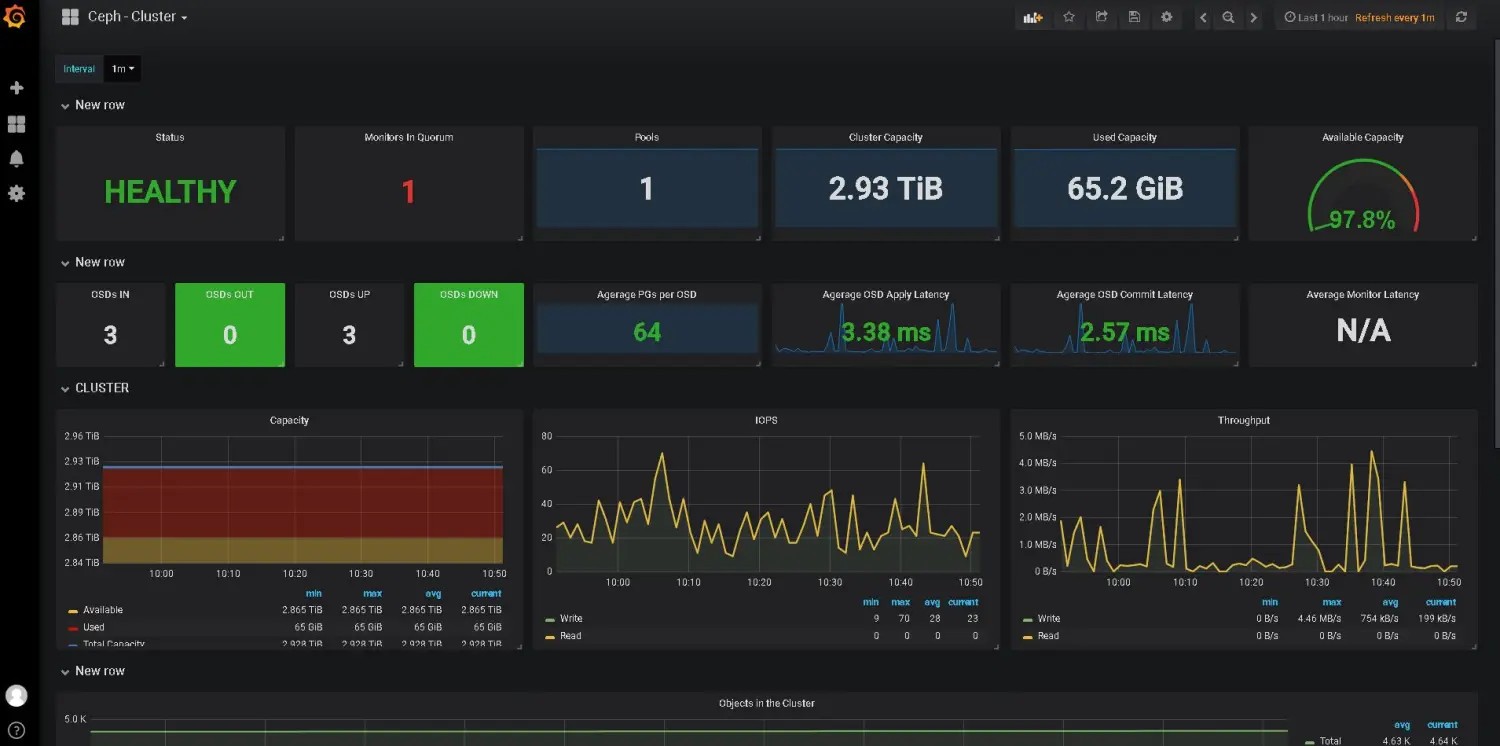

Ceph集群监控Prometheus+Grafana

Ceph是一个分布式存储系统。同时Ceph除了能提供块存储,还可以提供文件存储、对象存储。 这里不介绍如何搭建Ceph及原理,只记录使用Ceph_exporter + Prometheus + Grafana 来对Ceph集群作监控的部署过程 Ceph集群有三种节点:Admin + Monitor + Node Admin节点上部署Ceph_exporter 安装需要的软件golang 1yum install golang git librados2-devel librbd1-devel -y 设置go的环境变量 12345# /etc/profile.d/go.shexport GOROOT=/usr/lib/golangexport GOBIN=$GOROOT/binexport GOPATH=/home/golangexport PATH=$PATH:$GOROOT/bin:$GOPATH/bin 1source /etc/profile.d/go.sh 安装ceph_exporter 1go get -u github.com/digitalocean/...

Confluence容器化-+-Openshift-Confluence模板创建

因为应用容器化部署已经是标准化的流程,无需再详篇介绍具体的部署流程。所以本文只提供相关的配置文档。如果对部署过程不了解的同学,请先自学容器基础。镜像已经创建好了,如下 12docker.io/xhuaustc/confluence:6.7.1docker.io/xhuaustc/atlassian-mysql:5.7 镜像构建配置mysql镜像12345678910111213141516171819# my.cnf[mysqld]# Disabling symbolic-links is recommended to prevent assorted security riskssymbolic-links = 0# http://www.percona.com/blog/2008/05/31/dns-achilles-heel-mysql-installation/skip_name_resolve# http://www.chriscalender.com/ignoring-the-lostfound-directory-in-your-datadir/ignore-db-...

Docker中使用命令COPY-ADD导入文件对权限的影响

1、文件保留权限原文件的权限所属用户与组为镜像中的用户可以使用--chown=jenkins:jenkins来指定用户所属 1COPY --chown=1001:1001 sample.txt sample.txt 2、压缩包(ADD)保留权限原文件的权限保留压缩包内文件的用户与组

Docker安装镜像仓库的三种方法

一、docker-distribution 安装docker-distribution软件 1yum install docker-distribution 配置registry/config.yml文件 123456789101112# /etc/docker-distribution/registry/config.ymlversion: 0.1log:fields:service: registrystorage:cache:layerinfo: inmemoryfilesystem:rootdirectory: /var/lib/registryhttp:addr: :5000 启动docker-distribution服务 12systemctl start docker-distributionsystemctl enable docker-distribution 运维 二、运行容器registry直接运行docker run 12docker run -d -p 5000:5000 -v /data/registry:/var/lib/regi...

Jira容器化-+-Openshift-Jira模板创建

因为应用容器化部署已经是标准化的流程,无需再详篇介绍具体的部署流程。所以本文只提供相关的配置文档。如果对部署过程不了解的同学,请先自学容器基础。镜像已经创建好了,如下 12docker.io/xhuaustc/jira-software:7.11.0docker.io/xhuaustc/atlassian-mysql:5.7 镜像构建配置Jira容器构建 1git clone https://github.com/cptactionhank/docker-atlassian-jira-software 将setenv.sh与atlassian-extras-3.2.jar拷贝到docker-atlassian-jira-software 123456789101112131415161718192021222324252627282930313233343536373839404142434445464748495051525354555657585960616263646566676869707172737475767778798081828384858687888990919...

K8S-JFrog-DevOps实战训练营

DevOps CAMS模型C 文化 CultureA 自动化 AutomationM 指标维度 MeasurementS 分享 Sharing DevOps Five Stages 规范化技术栈 推进标准化 & 降低不一致性因素 扩展DevOps实践,开始从一个团队,再到第二个第三个,最后到整个公司 自动化基础框架交付(PaaS平台) 提供自服务能力(自定义编排) DevOps三步落地法 基于价值流的自动化持续交付,有六个实践,分别是:可视化、限制在制品、减少规模、减少交接数量、持续识别和拓展约束,以及在价值流中消除浪费。 每种架构一套标准化流水线 gitlab / jenkins / nexus / ansible Kanban 或 Sprint计划板实现可视化工作,价值流交付可视化 快速反馈,PaaS监控、应用监控prometheus / grafana持续反馈,交付之前快速反馈jmeter / redmood / senium DevOps度量Hygieia Docker跨主机网络 大二层网...

Kubernetes安装手册

Kubernetes在2014年开源后,很快便占据了容器编排的主导地位,成为容器编排的事实标准。那么Kubernetes的安装是了解它的第一步。目前有非常多的工具方法来实现Kubernetes的安装,收集了一些如下。 kubeadm:https://github.com/kubernetes/kubeadmkubeadm是官方提供的最为通用的一种部署方案。 kops:https://github.com/kubernetes/kopskops通过命令行创建,销毁,升级和维护生产级,高可用性的Kubernetes集群。目前正式支持AWS(Amazon Web Services),其中GCE和OpenStack处于beta测试阶段,而VMware vSphere处于alpha阶段。 kubespray:https://github.com/kubernetes-sigs/kubespraykubespray通过 Ansible Playbook 来定义系统与 Kubernetes 集群部署的任务。 KubeOperator: https://github.com/KubeOpera...

Kubernetes工具集(持续收集------)

Kubescope cliKubescope cli 是一个可以运行在本地或 Kubernetes 中的工具,可直接从 Docker Daemon 中收集容器指标并可视化。和 cAdvisor 等其他集群指标收集服务一样, kubescope cli 收集指标的周期是 1 秒(而不是 10-15 秒)。如果周期是 10-15 秒,你可能会在测试期间错过一些引发性能瓶颈的问题。如果你使用 cAdvisor 进行测试,每次都要使用新的 Pod 作为测试对象,因为 Kubernetes 在超过资源限制时就会将 Pod 杀死,然后重新启动一个全新的 Pod。而 kubescope cli 就没有这方面的忧虑,它直接从 Docker Daemon 中收集容器指标(你可以自定义收集指标的时间间隔),并使用正则表达式来选择和过滤你想要显示的容器。 KubeMarkKubemark是K8s官方提供的一个对K8s集群进行性能测试的工具。它可以模拟出一个K8s cluster(Kubemark cluster),不受资源限制,从而能够测试的集群规模比真实集群大的多。这个cluster中master...

Kubernetes更新etcd证书

在三台etcd所在的主机上执行以下操作 123456789$ cd /etc/kubernetes/pki$ mv etcd etcd.bak$ mkdir apiserver-etcd-client$ mv apiserver-etcd-client.* apiserver-etcd-client/$ kubeadm alpha phase certs etcd-ca$ kubeadm alpha phase certs etcd-server --config=/etc/kubernetes/kubeadmcfg.yaml$ kubeadm alpha phase certs etcd-peer --config=/etc/kubernetes/kubeadmcfg.yaml$ kubeadm alpha phase certs etcd-healthcheck-client --config=/etc/kubernetes/kubeadmcfg.yaml$ kubeadm alpha phase certs apiserver-etcd-client --config=/e...